Способен ли ИИ уничтожить человечество и если да, то как скоро?

Недавно исследователи в области криминалистики определили топ-18 угроз ИИ, о которых нам следует беспокоиться в ближайшие 15 лет. В то время как научная фантастика и популярная культура изображают гибель человечества от рук интеллектуальных роботов, результаты исследования показали, что главная угроза на самом деле имеет больше общего с нами, чем может показаться на первый взгляд.

По мнению Джонсона, чьи слова приводит Inverse, мы живем в постоянно меняющемся мире, который создает новые возможности – как хорошие, так и плохие. Вот почему так важно предвидеть будущие угрозы, в том числе рост преступности. Это необходимо, чтобы политики и другие заинтересованные стороны, обладающие компетенцией, могли выявить преступления еще до того, как они произойдут. Да, прямо как в фильме «Особое мнение» с Томом Крузом в главных ролях.

Хотя авторы работы, опубликованной в журнале Crime Science признают, что выводы исследования по своей сути носят спекулятивный характер и зависят от современной политической обстановки и технического развития, в будущем технологии и политика будут идти рука об руку.

Кадр из фильма «Осбое мнение»

Вред

Рентабельность

Достижимость

Поражаемость

Вред в данном случае может относиться к физическому, психическому или социальному ущербу. Авторы исследования далее определяют, что эти угрозы могут причинить вред, либо победив ИИ(например, уклоняясь от распознавания лиц), либо используя ИИ для совершения преступления (например, шантажируя людей с помощью deep fake — поддельного видео).

Хотя эти факторы на самом деле не могут быть отделены друг от друга, экспертам было предложено рассмотреть влияние этих критериев отдельно. Затем результаты команд были отсортированы, чтобы определить общие наиболее опасные угрозы со стороны ИИ в ближайшие 15 лет.

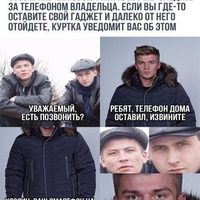

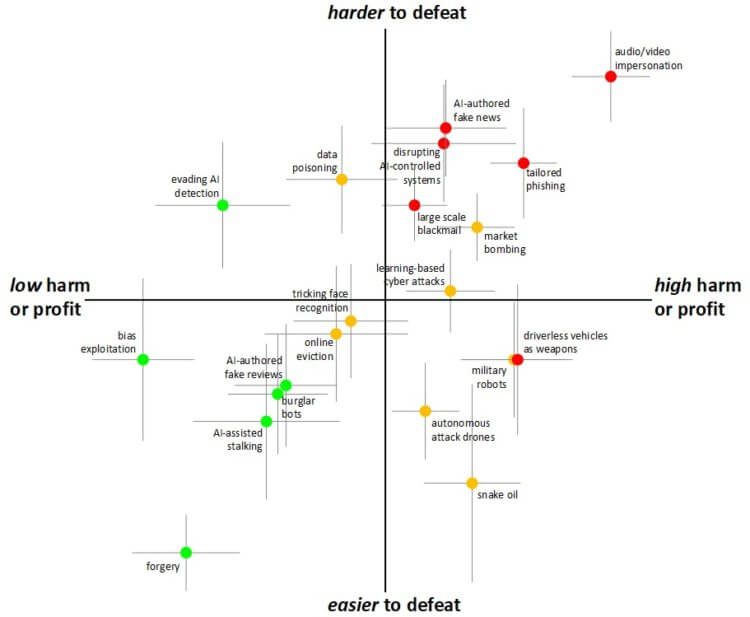

ИИ – диаграмма угроз

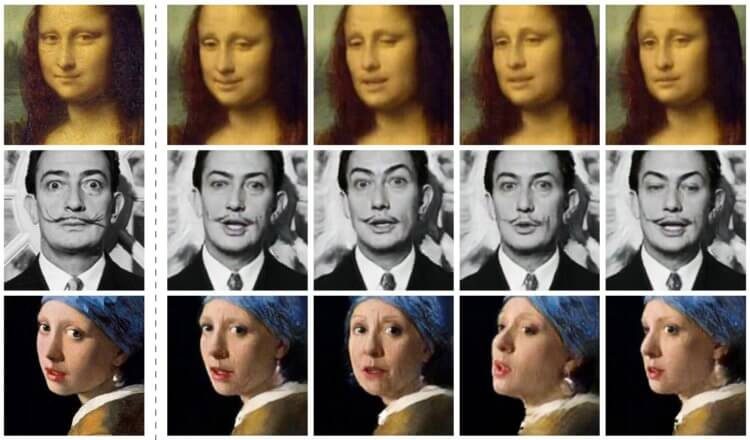

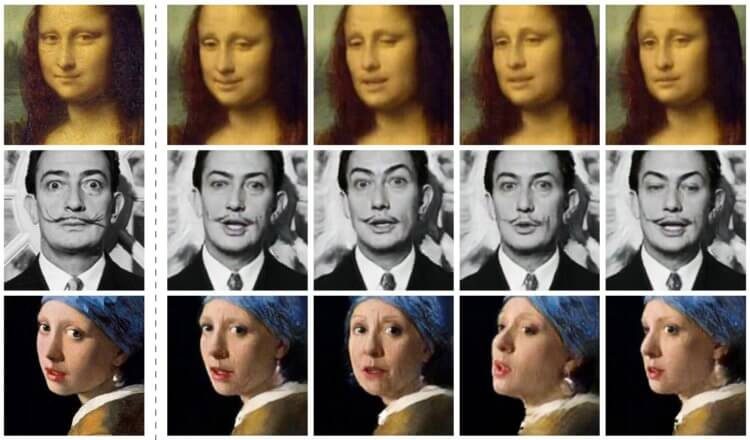

В отличие от роботизированной угрозы, способной причинить физический вред или повредить имуществу, deep fake способен лишить нас доверия к людям и самому обществу. Оценивая угрозы по вышеперечисленным критериям, группа исследователей определила, что deep fake — технология, которая уже существует и распространяется — представляют собой самый высокий уровень угрозы.

Важно понимать, что угрозы, которые несет в себе ИИ, несомненно, будут силой, с которой придется считаться в ближайшие годы.

Сравнивая 18 различных типов угроз ИИ, группа определила, что видео и аудиоманипуляции в форме deep fake являются самой большой угрозой.

«Люди имеют сильную тенденцию верить своим собственным глазам и ушам, поэтому аудио и видеодоказательствам традиционно придавалось большое доверие (и часто юридическая сила), несмотря на долгую историю фотографического обмана», — объясняют авторы. «Но недавние разработки в области обучения (в том чтсле и deep fake) значительно расширили возможности для генерации поддельного контента».

Авторы исследования считают, что потенциальное воздействие этих манипуляций варьируется от лиц, обманывающих пожилых людей, выдавая себя за члена семьи, до видео, предназначенных для того, чтобы сеять недоверие к общественным и правительственным деятелям. Они также добавляют, что эти атаки трудно обнаружить отдельным лицам (и даже экспертам в некоторых случаях), что затрудняет их остановку. Таким образом, изменения в поведении граждан могут быть единственной эффективной защитой.

Deep Fake – основная угроза ИИ

Другие главные угрозы включали автономные автомобили, используемые в качестве дистанционного оружия, подобные автомобильным террористические атаки, которые мы видели в последние годы, ИИ и фальшивых новостей (фейк-ньюс). Интересно, что группа считала роботов-взломщиков (маленьких роботов, которые могут пролезть через маленькие отверстия, чтобы украсть ключи и помочь грабителям и взломщикам) одной из самых незначительных угроз.

ИИ – это угроза?

Сегодня может показаться, что искусственный интеллект, представляющий угрозу для человечества – это удел научных фантастов и фильмов наподобие «Матрицы» или «Я-робот». Согласитесь, довольно сложно представить себе всемогущий и страшный ИИ, когда Siri не способна дать правильный прогноз погоды. Но Шейн Джонсон, директор Центра будущих преступлений Дауэса в Калифорнийском университете объясняет, что количество потенциальных угроз будет расти и они будут становится все сложнее и сложнее, переплетаясь с нашей повседневной жизнью.По мнению Джонсона, чьи слова приводит Inverse, мы живем в постоянно меняющемся мире, который создает новые возможности – как хорошие, так и плохие. Вот почему так важно предвидеть будущие угрозы, в том числе рост преступности. Это необходимо, чтобы политики и другие заинтересованные стороны, обладающие компетенцией, могли выявить преступления еще до того, как они произойдут. Да, прямо как в фильме «Особое мнение» с Томом Крузом в главных ролях.

Хотя авторы работы, опубликованной в журнале Crime Science признают, что выводы исследования по своей сути носят спекулятивный характер и зависят от современной политической обстановки и технического развития, в будущем технологии и политика будут идти рука об руку.

Кадр из фильма «Осбое мнение»

Искусственный интеллект и преступность

Для того чтобы сделать эти футуристические выводы, исследователи собрали команду из 14 ученых в смежных областях, семи экспертов из частного сектора и 10 экспертов из государственного сектора. Эти 30 экспертов были равномерно разделены на группы от четырех до шести человек и получили список потенциальных преступлений ИИ, начиная от физических угроз (например, автономная атака беспилотника) и заканчивая цифровыми формами угроз. Для того чтобы вынести свои суждения, команда рассмотрела четыре основные особенности атак:Вред

Рентабельность

Достижимость

Поражаемость

Вред в данном случае может относиться к физическому, психическому или социальному ущербу. Авторы исследования далее определяют, что эти угрозы могут причинить вред, либо победив ИИ(например, уклоняясь от распознавания лиц), либо используя ИИ для совершения преступления (например, шантажируя людей с помощью deep fake — поддельного видео).

Хотя эти факторы на самом деле не могут быть отделены друг от друга, экспертам было предложено рассмотреть влияние этих критериев отдельно. Затем результаты команд были отсортированы, чтобы определить общие наиболее опасные угрозы со стороны ИИ в ближайшие 15 лет.

ИИ – диаграмма угроз

В отличие от роботизированной угрозы, способной причинить физический вред или повредить имуществу, deep fake способен лишить нас доверия к людям и самому обществу. Оценивая угрозы по вышеперечисленным критериям, группа исследователей определила, что deep fake — технология, которая уже существует и распространяется — представляют собой самый высокий уровень угрозы.

Важно понимать, что угрозы, которые несет в себе ИИ, несомненно, будут силой, с которой придется считаться в ближайшие годы.

Сравнивая 18 различных типов угроз ИИ, группа определила, что видео и аудиоманипуляции в форме deep fake являются самой большой угрозой.

«Люди имеют сильную тенденцию верить своим собственным глазам и ушам, поэтому аудио и видеодоказательствам традиционно придавалось большое доверие (и часто юридическая сила), несмотря на долгую историю фотографического обмана», — объясняют авторы. «Но недавние разработки в области обучения (в том чтсле и deep fake) значительно расширили возможности для генерации поддельного контента».

Авторы исследования считают, что потенциальное воздействие этих манипуляций варьируется от лиц, обманывающих пожилых людей, выдавая себя за члена семьи, до видео, предназначенных для того, чтобы сеять недоверие к общественным и правительственным деятелям. Они также добавляют, что эти атаки трудно обнаружить отдельным лицам (и даже экспертам в некоторых случаях), что затрудняет их остановку. Таким образом, изменения в поведении граждан могут быть единственной эффективной защитой.

Deep Fake – основная угроза ИИ

Другие главные угрозы включали автономные автомобили, используемые в качестве дистанционного оружия, подобные автомобильным террористические атаки, которые мы видели в последние годы, ИИ и фальшивых новостей (фейк-ньюс). Интересно, что группа считала роботов-взломщиков (маленьких роботов, которые могут пролезть через маленькие отверстия, чтобы украсть ключи и помочь грабителям и взломщикам) одной из самых незначительных угроз.

Мы обречены?

Нет, но у нас есть кое-какая работа. Популярные изображения угроз ИИ предполагают, что у нас будет одна красная кнопка для нажатия, которая может заставить всех гнусных роботов и компьютеры остановиться. На самом деле угроза заключается не столько в самих роботах, сколько в том, как мы используем их, чтобы манипулировать и вредить друг другу. Понимание этого потенциального вреда и все возможное, чтобы опередить его в форме информационной грамотности и создания сообщества, может стать мощным инструментом против этого более реалистичного апокалипсиса роботов.

Только зарегистрированные и авторизованные пользователи могут оставлять комментарии.

+2

всё гораздо проще, будет примерно так stihi.ru/2017/09/18/8809

- ↓

+1

Слишком примитивно.

- ↑

- ↓

+1

у каждого свой конец света. весь вопрос — когда и от чего.

- ↓

+2

мы все умрем. эх!

- ↓

+1

в 1501 г. образовалось государство Сефевидов и 14 летний шейх Исмаил стал шахом

- ↑

- ↓