ИИ провалил школьный математический тест

Простому обывателю (человеку, не связанному с IT-сферой) может показаться, что вот-вот появится настоящий, «большой» искусственный интеллект, о котором пишут фантасты и снимают фильмы. Но на самом деле всё не так радужно.

В онлайн-репозитории научных работ arXiv появилась статья «Analyzing Mathematical Reasoning Abilities of Neural Models», в которой рассказывается о том, как искусственный интеллект компании DeepMind не справился со стандартным математическим тестом, который обычно сдают британские ученики старшей школы.

Причины неудачи можно объяснить без особого труда. Так, человек при решении задач математического характера задействует следующие способности и возможности:

Модифицирует для себя символы в сущности, такие как числа, арифметические операторы, переменные (которые в комплексе образуют функции) и слова (определяющие вопрос, смысл задачи);

Проводит планирование (например, ранжируя функции в порядке, необходимом для решения математической задачи);

Использует вспомогательные алгоритмы для составления функций (сложение, умножение);

Использует кратковременную память для хранения промежуточных значений (например, h (f (x)));

Применяет на практике полученных ранее знаний о правилах, преобразованиях, процессах и аксиомах.

DeepMind обучали и тестировали свой ИИ на подборке различных типов математических проблем и задач. Разработчики не использовали краудсорсинг, вместо этого они синтезировали набор данных для генерации большого количества тестовых задач, контроля уровня их сложности и т.п. Команда разработчиков использовала текстовый формат данных «произвольной формы».

Данные базировались на задачах из подборок заданий для британских школьников возрастом до 16 лет. Задания брались из таких направлений, как арифметика, алгебра, теория вероятностей и других.

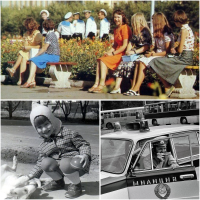

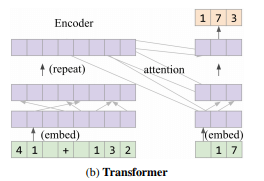

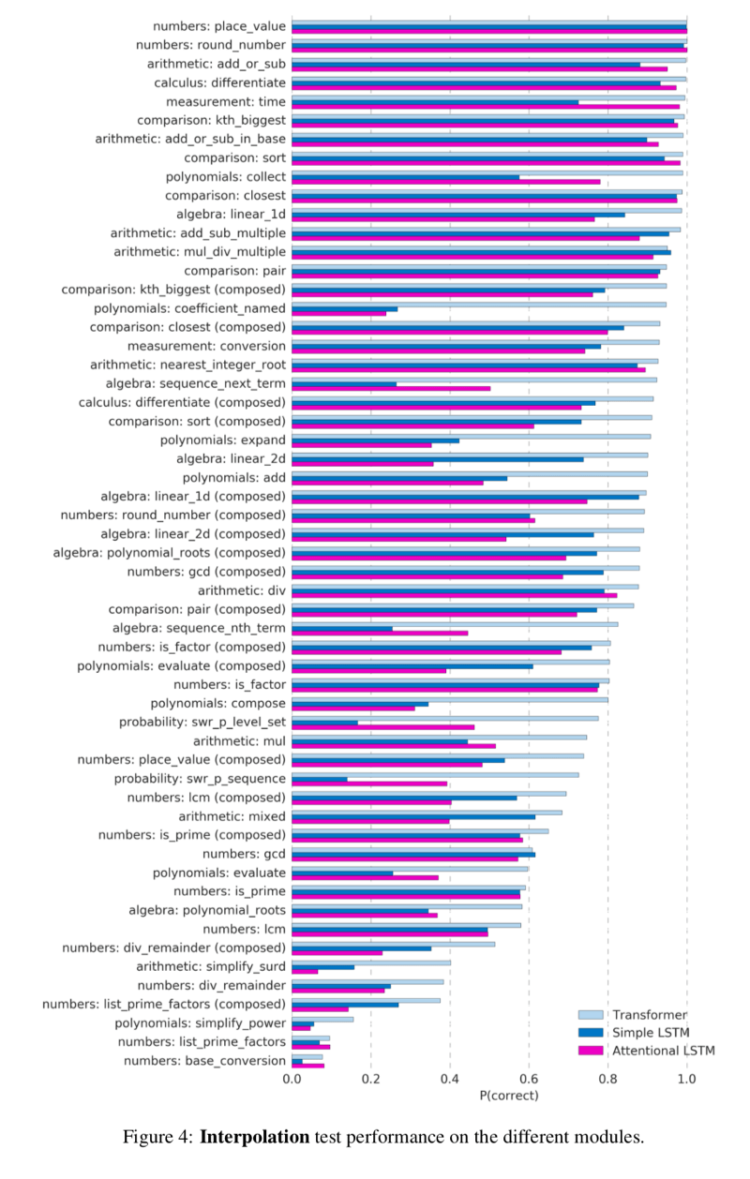

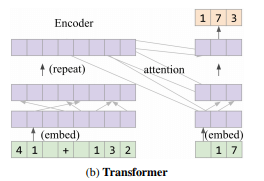

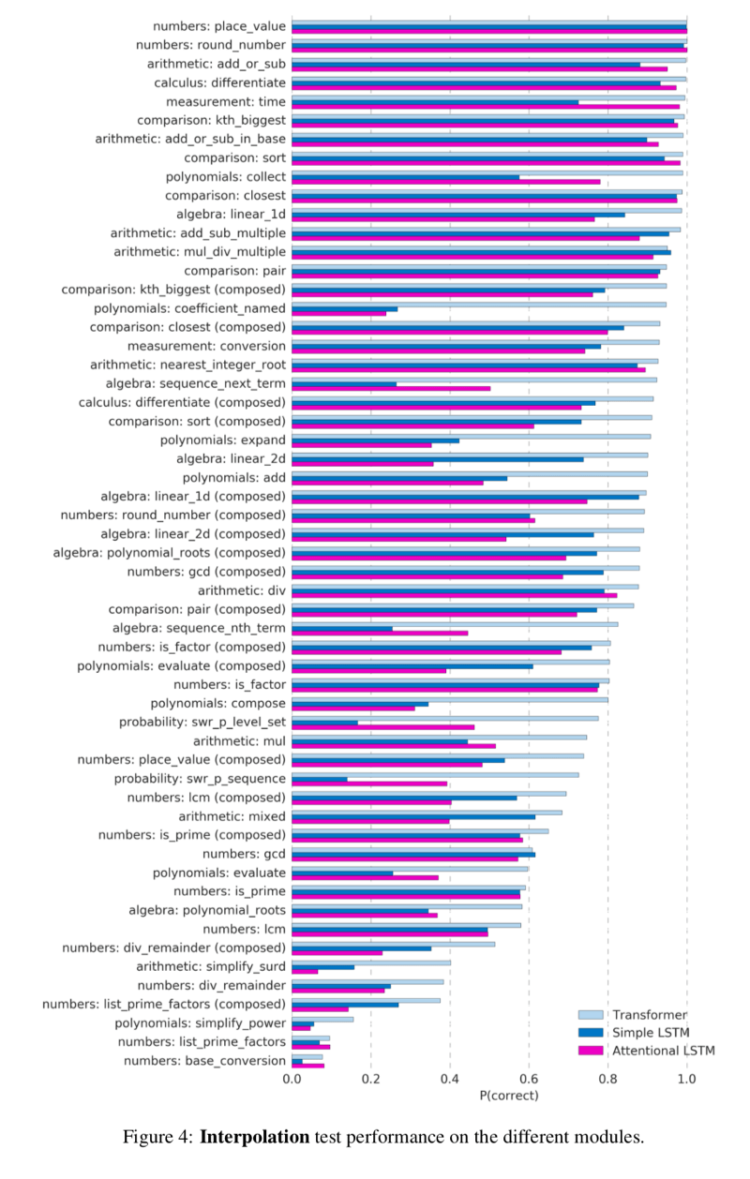

При выборе архитектуры нейросети для решения математических задач, команда DeepMind остановилась на LSTM (долгая краткосрочная память) и Transformer (архитектура нейросетей для работы с последовательностями). Специалисты протестировали две модели LSTM для работы с математическими задачами: простой LSTM и Attentional LSTM. Его схема работы показана на рисунке ниже.

Архитектура Attentional LSTM

Модель архитектуры Transformer

В статье, описывающей результаты этого исследования отмечается, что эти результаты оказались не очень хорошими. Искусственный интеллект смог справиться лишь с 35 процентами задач (из 40 предоставленных заданий), дав на них правильные ответы. По стандартам любой школы — неудовлетворительно.

В онлайн-репозитории научных работ arXiv появилась статья «Analyzing Mathematical Reasoning Abilities of Neural Models», в которой рассказывается о том, как искусственный интеллект компании DeepMind не справился со стандартным математическим тестом, который обычно сдают британские ученики старшей школы.

Причины неудачи можно объяснить без особого труда. Так, человек при решении задач математического характера задействует следующие способности и возможности:

Модифицирует для себя символы в сущности, такие как числа, арифметические операторы, переменные (которые в комплексе образуют функции) и слова (определяющие вопрос, смысл задачи);

Проводит планирование (например, ранжируя функции в порядке, необходимом для решения математической задачи);

Использует вспомогательные алгоритмы для составления функций (сложение, умножение);

Использует кратковременную память для хранения промежуточных значений (например, h (f (x)));

Применяет на практике полученных ранее знаний о правилах, преобразованиях, процессах и аксиомах.

DeepMind обучали и тестировали свой ИИ на подборке различных типов математических проблем и задач. Разработчики не использовали краудсорсинг, вместо этого они синтезировали набор данных для генерации большого количества тестовых задач, контроля уровня их сложности и т.п. Команда разработчиков использовала текстовый формат данных «произвольной формы».

Данные базировались на задачах из подборок заданий для британских школьников возрастом до 16 лет. Задания брались из таких направлений, как арифметика, алгебра, теория вероятностей и других.

При выборе архитектуры нейросети для решения математических задач, команда DeepMind остановилась на LSTM (долгая краткосрочная память) и Transformer (архитектура нейросетей для работы с последовательностями). Специалисты протестировали две модели LSTM для работы с математическими задачами: простой LSTM и Attentional LSTM. Его схема работы показана на рисунке ниже.

Архитектура Attentional LSTM

Модель архитектуры Transformer

В статье, описывающей результаты этого исследования отмечается, что эти результаты оказались не очень хорошими. Искусственный интеллект смог справиться лишь с 35 процентами задач (из 40 предоставленных заданий), дав на них правильные ответы. По стандартам любой школы — неудовлетворительно.

Только зарегистрированные и авторизованные пользователи могут оставлять комментарии.

+3

Какие разработчики — такой и ИИ.

- ↓

+1

Скорее всего так. И грамотно поставить задачу машине тоже не менее важно.

- ↑

- ↓

+1

Это на самом деле САМОЕ важное.

- ↑

- ↓

0

помоги им

- ↑

- ↓